Londres es la segunda ciudad más monitorizada del mundo — después de Pekín — con 420 mil cámaras repartidas en espacios públicos y privados. Los agentes se ocultaron en una furgoneta con ordenadores en su interior. Si algún ciudadano se percataba de que estaba siendo vigilado y ocultaba el rostro, un policía se le acercaba para pedirle que facilitara el reconocimiento facial. A una queja insistente, le caía una multa. Aquel día, cuatro personas fueron arrestadas por no querer mostrar su cara.

El Servicio de Inmigración y Control de Aduanas de los Estados Unidos utiliza un sistema similar al de la policía británica, pero con millones de fotografías del carnet de conducir. Y FaceApp — la aplicación viral presentada como un entretenimiento que recrea la niñez y vejez de cualquier persona — entrena su sistema con millones de caras concedidas gratuitamente, aunque sea sin leer los términos de uso y su cláusula de privacidad.

Porque en esta cláusula se explicita que la persona concede una “licencia perpetua, irrevocable, no exclusiva, mundial y gratuita” de todos sus datos personales. Y añade que “comparte la información con terceros”. Lo que no se cuenta es que estos ‘terceros’ pueden ser un gobierno, una policía con la intención de cruzar los rostros con datos de criminalidad o cualquier otra empresa ubicada en otro país, con regulaciones bien distintas a las del usuario.

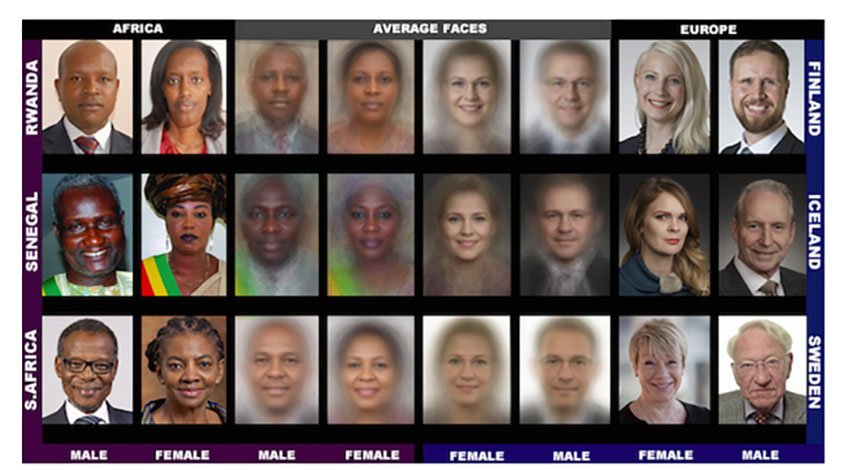

¿Debería preocuparnos este funcionamiento? Quizás no. Quizás nos debería preocupar mucho más el sesgo de los algoritmos de reconocimiento facial que discriminan injustamente a las mujeres y los que no son blancos, porque los obvia o los señala, culpabilizándolos sin motivo.

Sin consentimiento y con sesgos

Actualmente, muchos de los dispositivos que reconocen las huellas digitales, la voz, la cara o el iris usan redes neuronales — algoritmos complejos que requieren grandes cantidades de datos para reconocer patrones — . Para que sean más precisos, se introducen en el sistema millones de etiquetas que van entrenando la máquina.

El problema es que los algoritmos no son neutros. Tampoco los datos que sirven para entrenarlos, porque tienen sesgos. Y esto no es nada nuevo. Los sesgos son parecidos a los prejuicios: todos los tenemos, en menor o mayor grado. Si los sesgos no se corrigen, hay el riesgo de habitar en un futuro donde cada vez sea más difícil el progreso social porque los prejuicios se perpetúan.

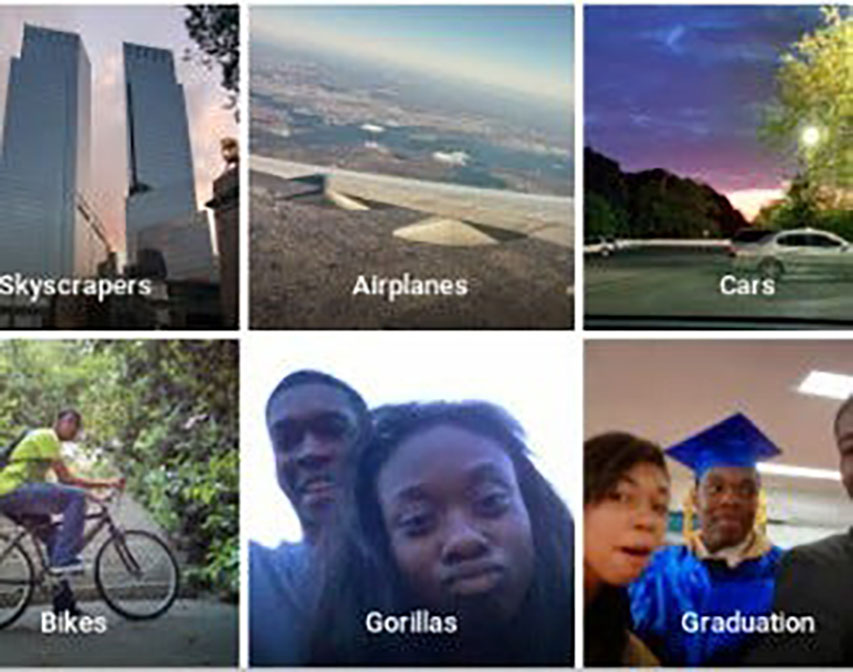

En los últimos años, se han detectado y denunciado ampliamente los sesgos de los algoritmos para el reconocimiento facial porque discriminan, especialmente con caras no blancas y no masculinas. Por ejemplo, en 2015, Google Photos clasificó a algunas personas negras como ‘gorilas’. Su solución inicial fue eliminar ciertas etiquetas, como el término “gorilas”, en lugar de arreglar el modelo en sí. El año pasado, el programa Rekognition de Amazon identificó erróneamente a 28 de los 435 miembros del congreso como delincuentes.

Un último ejemplo es el de la compañía francesa IDEMIA: su programa escanea millones de caras y las sirve a la policía de los Estados Unidos, Australia y Francia. Pero sus algoritmos no siempre ven todas las caras con la misma claridad, es como si algunas, las más oscuras, no existieran. El Instituto Nacional de Estándares y Tecnología (NIST) de EE.UU. indicó en su evaluación del pasado julio que dos de los sistemas tenían muchas más probabilidades de confundir los rostros de las mujeres negras que los de las mujeres blancas.

¿Por qué tienen estos errores o sesgos los sistemas inteligentes? Porque el aprendizaje de la máquina se basa en los datos de entrenamiento. Pero no se puede aprender lo que no está en ellos. Y ésta es la principal razón de los problemas actuales en sistemas de reconocimiento de caras, coches sin conductor, etc.

El proyecto Gender Shades — dedicado a estudiar los sesgos en el reconocimiento facial — también concluye que los sistemas actuales tienen menos precisión cuando han de clasificar rostros femeninos oscuros, comparado con el resto de caras.

Numerosos ejemplos dejan claro que el reconocimiento facial sin consentimiento, con fines no especificados, ya se está aplicando en todo el mundo. Se sabe también que todos los algoritmos que facilitan esta función tienen sesgos, con las consecuentes repercusiones.

Tener conciencia de la existencia de las desviaciones de los algoritmos es el principal paso para cambiar la situación actual. Y cuando decimos ‘tener conciencia’ nos referimos a tener interés por el funcionamiento de la tecnología que facilita cualquier faceta de nuestra vida personal o pública, e interés por entender a qué estamos accediendo al aceptar una cláusula de privacidad, así como los posibles riesgos y errores que todo ello comporta.