¿Acaso no había ninguna candidata con aptitudes?

Este ejemplo de Amazon –un clásico ya de los errores que la IA ha provocado recientemente– responde al título de este artículo. Los datos masivos que sirvieron para alimentar el algoritmo de selección de personal se basaron en currículos recibidos en la última década, donde la mayoría de los programadores eran hombres. Cuando el sistema automático detectaba la palabra ‘mujer’ –o un sinónimo–, directamente lo penalizaba poniéndole menos puntuación.

En 2016 investigadores de Microsoft Research y de la Universidad de Boston usaron una colección masiva de noticias de Google para aprender sobre los estereotipos femenino/masculino redactados en artículos de prensa.

Entre otros resultados sesgados, encontraron que cuando ellos eran programadores informáticos, ellas eran amas de casa. O cuando ellos eran médicos, entonces ellas eran enfermeras. Y tiene su lógica, porque en Estados Unidos la mayoría de periodistas son hombres, así que Google sólo reflejaba el sesgo de género existente en la realidad.

Esta investigación fue presentada en uno de los principales congresos de aprendizaje automático del mundo, NIPS, de la fundación de igual nombre (Foundation for Neural Information Processing Systems). Un año más tarde hubo un escándalo sexual con un investigador de Google y luego el acrónimo del congreso –que en inglés es un sinónimo informal de ‘pezones’ (nipples)– ocasionó una protesta femenina que obligó, en 2018, a cambiar el nombre del evento por el de NeurIPS.

Estos estereotipos de género están presentes también en otros sistemas que usan texto para aprender, como el traductor de Google. Si traducimos del castellano al turco y del turco al castellano, la frase cambia discriminando a las mujeres. Y tiene una explicación, como todo. En turco los pronombres no tienen género. Así que el sistema usa la traducción más común en el segundo paso, es decir, que la mujer sea la niñera y el hombre el doctor, tal como se muestra abajo.

Los ejemplos anteriores muestran como un sistema automatizado reproduce el sesgo de género si éste existe previamente en la sociedad, más aún si la mayoría de los programadores son hombres. Esto ocurre incluso si el género es eliminado de los datos de entrenamiento, pues el contexto está correlacionado con el mismo.

Lo mismo pasa con otros colectivos, ya sea por motivos de raza, religión o clase social, por mencionar los sesgos más importantes. Sabiendo esto, ¿cómo evitar que la IA perjudique a las mujeres más que a los hombres?

Detectar y mitigar

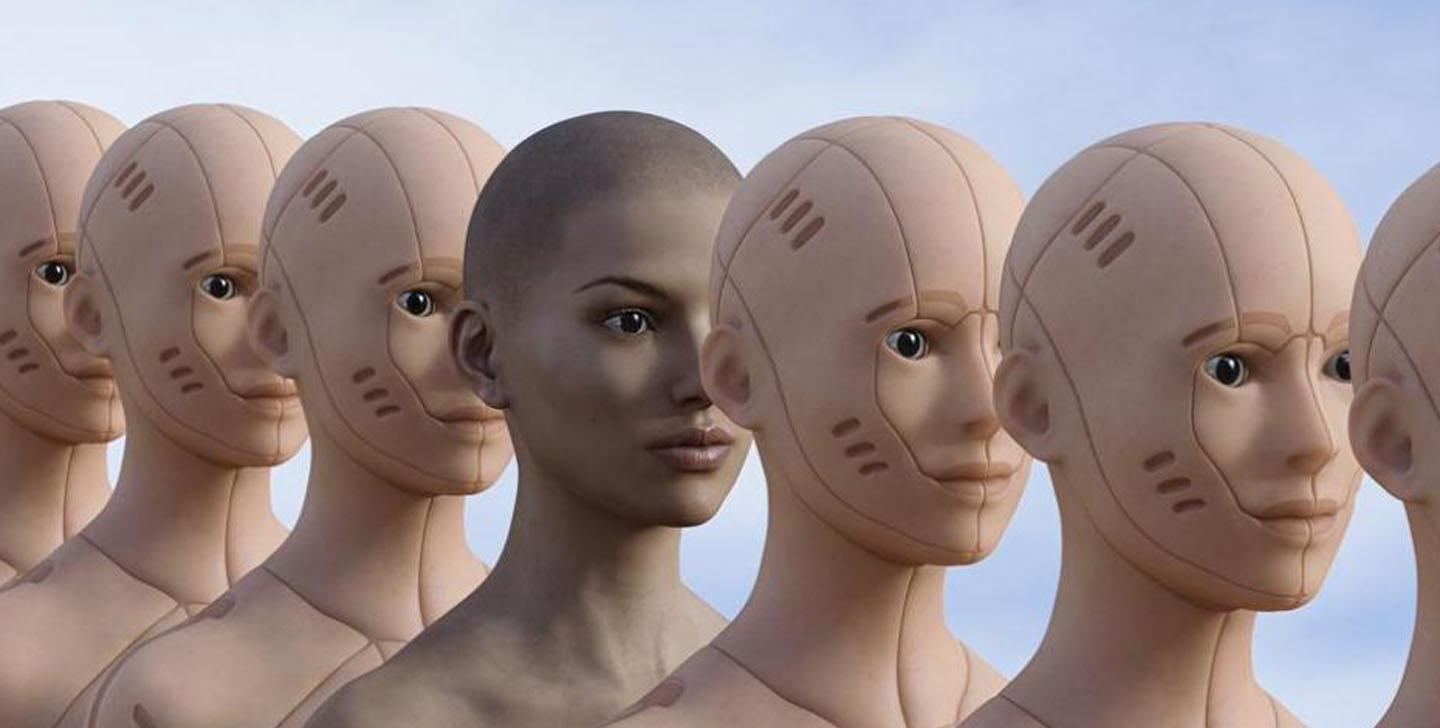

En primer lugar, construyendo mejores datos de entrenamiento. Esto implica que, por ejemplo, la mitad de las caras de una colección de datos sean de mujeres y que haya diversidad de ellas teniendo en cuenta la raza, color de pelo, expresiones, etc.

En segundo lugar, que la categorización no tenga subcategorías con sesgo negativo, como bruja para nombrar a una mujer. Por último, debemos evitar que las personas que etiquetan caras no utilicen sus sesgos personales para perpetuar y amplificar estereotipos. Es decir, al mismo tiempo que los sistemas aprenden de nosotros, también debieran enseñarnos a ser conscientes de nuestros sesgos y a mejorarnos como persona.

El Grupo de Investigación de Ciencia de la Web y Computación Social de la Universitat Pompeu Fabra (al que pertenece el autor masculino de este artículo), junto con la Universidad Técnica de Berlín y el Centro Tecnológico Eurecat, ha creado un algoritmo para evitar este tipo de discriminaciones en buscadores.

“Estudiamos datos de ofertas de empleo, de reincidencia de presos y rankings de admisión a las universidades para detectar patrones de discriminación en directorios que puedan favorecer o relegar a ciertos colectivos”, explica Carlos Castillo, director del grupo.

Al algoritmo justo lo han llamado FA*IR y es parte del trabajo de una de sus alumnas de doctorado, Meike Zehlike. Otra de sus alumnas, Sara Galindo, estudió en su máster cómo eran clasificados los hombres y mujeres profesionales en LinkedIn y Viadeo.

“Si hay 100 perfiles de hombres y mujeres igualmente cualificados y en los primeros resultados del buscador solo aparecen hombres, tenemos un problema”.

¿Cómo funciona? FA*IR detecta este tipo de discriminación y la corrige incorporando “un mecanismo de acción positiva” para “reordenar los resultados y evitar la discriminación sin afectar la validez del ranking”.

Transparencia algorítmica

Admitiendo que los algoritmos de decisión automática influyen en nuestra vida personal y profesional, quizás debamos dar un paso más y pedir la transparencia algorítmica. Como mínimo que nos digan qué objetivo hay detrás de cada proceso automatizado.

Al respecto, la investigadora Sandra Wachter –que trabaja en las implicaciones legales y éticas de la inteligencia artificial, el aprendizaje automático y la robótica– propone que empresas y administraciones públicas den “explicaciones contra factuales” a sus usuarios/ciudadanos.

“La gente no quiere saber cómo se hizo el algoritmo, sólo por qué motivo fue discriminado/a o por qué no consiguió un trabajo”, explica Wachter.

Y la manera más fácil, según la investigadora es respondiendo a preguntas simples: “¿Si ganara 10 mil euros más al año me habrían concedido la hipoteca? ¿Si tuviera una carrera universitaria, me habrían escogido para el trabajo?”.

La solución de Wachter podría ser de gran interés tanto para el sector público –que tiene necesidad de que la ciudadanía adopte de buen grado la tecnología–, como para el privado, porque no tendría que revelar cómo se ha diseñado el algoritmo.

Si nunca se reveló la fórmula de la Coca-Cola, mucho menos se va a conseguir con los algoritmos, cuando la inteligencia artificial ya rinde beneficios multimillonarios. Pero si gobiernos e instituciones conceden la palabra a la ciudadanía, quizás avancemos hacia un mundo más justo. Cataluña ya ha dado un primer paso publicando una Estrategia de Inteligencia Artificial con derecho a contribuciones ciudadanas hasta mediados de octubre.

Nota: tanto en el título como en el texto usamos IA para referirnos a “sistemas basados en aprendizaje automático” que son un subconjunto de la IA, pero que actualmente son términos que la mayor parte de la gente no distingue.